はじめに:なぜ今、RAGが重要なのか?

大規模言語モデル(LLM)は、その驚異的な文章生成能力で世界を席巻しています。しかし、その能力にはいくつかの根源的な課題が存在します。

- 知識の静的性(Knowledge Cutoff): LLMの知識は、学習データが収集された特定の時点までで固定されています。そのため、最新の出来事や新しい情報について質問しても答えることができません。

- ハルシネーション(Hallucination): LLMは、知らない情報についても、あたかも事実であるかのように、もっともらしい嘘の情報を生成してしまうことがあります。

- 情報の不透明性: LLMがなぜその回答を生成したのか、その根拠となる情報源が何であるかを知ることは困難です。

これらの課題を解決する強力なソリューションとして登場したのが、**RAG(Retrieval-Augmented Generation:検索拡張生成)**です。RAGは、その名の通り「検索(Retrieval)」によって外部の信頼できる情報源から関連知識を取得し、それを「補強(Augmented)」材料としてLLMに与えることで、より正確で根拠のある「生成(Generation)」を可能にする技術です。

本記事では、このRAGの様々なアーキテクチャを図解と共に、基本から応用、そして未来の形までを2 Partにわたって徹底的に解説していきます。

RAGを構成するコア・コンポーネント詳解

まず、アーキテクチャを理解する上で不可欠な、図に登場する各要素(コンポーネント)の役割をより深く見ていきましょう。

| 名称 | 詳細な役割と技術的背景 |

|---|---|

| 埋め込みモデル (Embedding Model) | テキストや画像などの情報を、機械が扱いやすい高次元の「ベクトル(数値のリスト)」に変換するAIモデル。Sentence-BERTやOpenAIのtext-embeddingシリーズなどが有名です。このモデルの性能が、後述するベクトル検索の精度を大きく左右します。重要なのは、意味的に近い概念がベクトル空間上で近い位置に配置されるように学習されている点です。 |

| ベクトルデータベース (Vector DB) | 埋め込みモデルによって生成された大量のベクトルデータを格納し、**高速な類似性検索(近似最近傍探索: ANN)**を実行するために特化したデータベースです。従来のデータベースが完全一致で検索するのに対し、ベクトルDBは「意味が近いもの」を探し出すのが得意です。Pinecone、Milvus、Chromaなどが代表的な製品です。 |

| 生成モデル (Generative Model) | 一般的にLLMと呼ばれるコンポーネントです。ユーザーのクエリ(質問)と、ベクトルDBなどから検索してきたコンテキスト(文脈情報)の両方を受け取り、それらを基に最終的な回答文を生成します。GPT-4、Claude 3、Geminiなどがこれにあたります。 |

| リランカーモデル (Reranker Model) | 検索結果の精度をさらに高めるための専門モデル。ベクトル検索は高速ですが、必ずしも最も関連性の高いものがトップに来るとは限りません。リランカーは、検索で取得した候補リスト(例:上位20件)を、クエリとの関連性をより精密に計算し直し(クロスエンコーダー方式など)、最適な順序に並べ替える役割を担います。Cohere Rerankなどが有名です。 |

| プロンプトテンプレート (Prompt Template) | LLMへの指示書(プロンプト)の雛形です。「以下のコンテキスト情報を参考にして、次の質問に答えてください。コンテキスト: {context}, 質問: {query}」といった形式で、検索結果とユーザーの質問をLLMが理解しやすいように整形します。プロンプトの設計(プロンプトエンジニアリング)はRAGの性能に大きく影響します。 |

| AIエージェント (AI Agent) | 与えられたタスクを自律的に計画し、ツールを使いこなし、意思決定を行う高度なAIです。単純な処理フローではなく、「思考→行動→観察」のループを回しながら、複雑な問題解決を目指します。後述するエージェント型RAGでは中心的な役割を果たします。 |

アーキテクチャ解説 Part 1:基本形とその進化

1. ナイーブRAG (Naive RAG) – すべての基本

「ナイーブ(素朴な)RAG」は、その名の通り最もシンプルで基本的なRAGの実装形態です。

仕組み

-

事前準備(Indexing):

- チャンキング: まず、情報源となるドキュメント(PDF、Webページなど)を、LLMが一度に処理できる適切なサイズのかたまり(チャンク)に分割します。このチャンクのサイズ設定は非常に重要で、小さすぎると文脈が失われ、大きすぎるとノイズが多くなります。

- 埋め込みと格納: 分割した各チャンクを「埋め込みモデル」に通してベクトル化し、そのベクトルと元のテキストをペアにして「ベクトルデータベース」に保存します。この一連の作業がインデックス作成です。

-

実行時(Retrieval & Generation):

- クエリの埋め込み: ユーザーのクエリ(質問)も、インデックス作成時と同じ埋め込みモデルでベクトル化します。

- 類似性検索: クエリのベクトルを使い、ベクトルDB内で最もベクトルが近い(=意味が似ている)チャンクをいくつか検索して取得します。

- 生成: 取得したチャンク(コンテキスト)と元のクエリを「プロンプトテンプレート」に組み込み、LLMに渡して回答を生成させます。

メリットと課題

- メリット: 実装が比較的容易で、RAGの基本的な恩恵(ハルシネーション抑制、情報源の明示)を受けることができます。

- 課題(限界点):

- 検索精度の限界: 検索結果が常に最適とは限らず、関連性の低いチャンクやノイズの多いチャンクを取得してしまうことがあります。

- 情報の見落とし: LLMは与えられたコンテキストが長すぎると、その中央部分の情報を無視・見落としてしまう「Lost in the Middle」という現象が知られています。ナイーブRAGではこの問題が起こりがちです。

- 画一的な処理: 質問の性質に関わらず、常に同じ方法で検索・生成を行うため、複雑な問いには対応しきれません。

これらの課題を克服するために、より高度なアーキテクチャが考案されました。

2. Retrieve-and-rerank – 検索精度を高める一手間

ナイーブRAGの「検索精度の限界」という課題に直接アプローチするのが、この「Retrieve-and-rerank」アーキテクチャです。

仕組み

このアーキテクチャは、ナイーブRAGの検索ステップを2段階に分割します。

-

第1段階:検索(Retrieve / Recall)

- ナイーブRAGと同様に、ベクトル検索で関連する可能性のあるチャンクを、意図的に多めに取得します(例:上位20件など)。ここでは速度が重視され、「候補を広く拾い上げること(Recall:再現率)」が目的です。

-

第2段階:再ランク付け(Rerank / Precision)

- 取得した20件のチャンクを、今度は「リランカーモデル」に渡します。

- リランカーモデルは、各チャンクを「元のクエリ」とペアにして、一つ一つじっくりと関連性をスコアリングします。これは計算コストが高い処理ですが、非常に高精度です。

- スコアに基づいてチャンクを並べ替え、本当に質の高い上位数件(例:上位3件)だけを厳選します。ここでは「適合率(Precision)」が重視されます。

-

生成(Generation)

- 厳選された高品質なコンテキストのみをLLMに渡し、回答を生成させます。

メリットと考慮点

- メリット: LLMに渡す情報の「ノイズ」が大幅に削減され、「シグナル(本当に必要な情報)」の割合が高まります。これにより、回答の精度が劇的に向上し、「Lost in the the Middle」問題も緩和されます。

- 考慮点: リランカーの処理が追加されるため、ナイーブRAGに比べて応答時間(レイテンシ)が長くなり、計算コストも増加します。リアルタイム性が求められるアプリケーションでは、このトレードオフを考慮する必要があります。

アーキテクチャ解説 Part 2:応用と未来の形

3. マルチモーダルRAG (Multimodal RAG) – テキストの壁を超える

現代の情報はテキストだけではありません。画像、音声、動画、図表など、多様な形式(モダリティ)で存在します。これらの非テキスト情報をLLMが理解し、活用できるようにするのが「マルチモーダルRAG」です。

仕組み

このアーキテクチャの鍵は、テキストと他のモダリティ(図では画像)を統一的に扱えるマルチモーダルモデルの存在です。

-

インデックス作成:

- マルチモーダル埋め込み: テキストと画像を含む「マルチモーダルドキュメント」を、専用の「マルチモーダル埋め込みモデル」(例:

CLIP)に通します。このモデルは、画像とその説明文を同じベクトル空間上に配置する能力を持っており、例えば「犬の写真」のベクトルと「"dog"という単語」のベクトルが近くなるように学習されています。 - 生成されたマルチモーダルベクトルをベクトルDBに格納します。

- マルチモーダル埋め込み: テキストと画像を含む「マルチモーダルドキュメント」を、専用の「マルチモーダル埋め込みモデル」(例:

-

検索・生成:

- マルチモーダルクエリ: ユーザーはテキスト(例:「この写真に写っている橋の名前は?」)と画像の両方をクエリとして入力できます。

- 検索: クエリを同様にマルチモーダル埋め込みモデルでベクトル化し、DBから関連性の高いデータ(画像やテキストチャンク)を取得します。

- 生成: 取得したコンテキストと元のクエリを「マルチモーダル生成モデル」(例:

GPT-4o,Gemini)に渡します。このモデルは、テキストと画像を同時に入力として受け取り、それらを統合して理解し、テキストや画像を含むレスポンスを生成する能力があります。

ユースケースと可能性

- ビジュアルQ&A: 製品の取扱説明書の図を見ながら、「この部品の取り付け方を教えて」と質問する。

- 医療画像診断の補助: レントゲン写真と共に「この画像で懸念される所見はありますか?」と問いかけ、関連する過去の症例や医学文献を検索して回答を生成する。

- クリエイティブなコンテンツ生成: 「この風景画のスタイルで、猫の絵を描いて」といった指示に応える。

マルチモーダルRAGは、LLMの応用範囲を劇的に広げる可能性を秘めています。

4. グラフRAG (Graph RAG) – 関係性を知識として活用する

ドキュメントは単なるテキストの集合体ではありません。その中にはエンティティ(人、組織、場所、概念など)と、それらの間の複雑な関係性が隠されています。この関係性を明示的な構造(グラフ)として抽出し、活用するのが「グラフRAG」です。

仕組み

-

インデックス作成:

- 知識グラフ抽出: ドキュメントを「LLMグラフジェネレーター」などのツールに通し、テキスト内からエンティティ(ノード)とその関係性(エッジ)を抽出して「知識グラフ」を構築します。

- 構築した知識グラフを、専用の「グラフデータベース」(例:

Neo4j)に格納します。

-

検索・生成:

- グラフ検索: ユーザーのクエリが来ると、単純なキーワードマッチングではなく、グラフDBに対して構造化クエリ(例: Cypher)を発行します。これにより、「A社が買収した企業の子会社は?」といった多段的な関係性を辿る検索が可能になります。

- コンテキスト取得: 検索結果として得られた関連ノードやサブグラフをコンテキストとして取得します。

- 生成: この構造化されたコンテキストをLLMに渡すことで、単なるチャンクを渡すよりもはるかに正確で深い洞察に基づいた回答が期待できます。

メリット

- 高精度な回答: 関係性が明確なため、複雑な質問に対して非常に正確な回答が可能です。

- 解釈可能性の向上: 回答の根拠がグラフ上のどのパスを辿ったかによって示されるため、なぜその結論に至ったのかが分かりやすくなります。

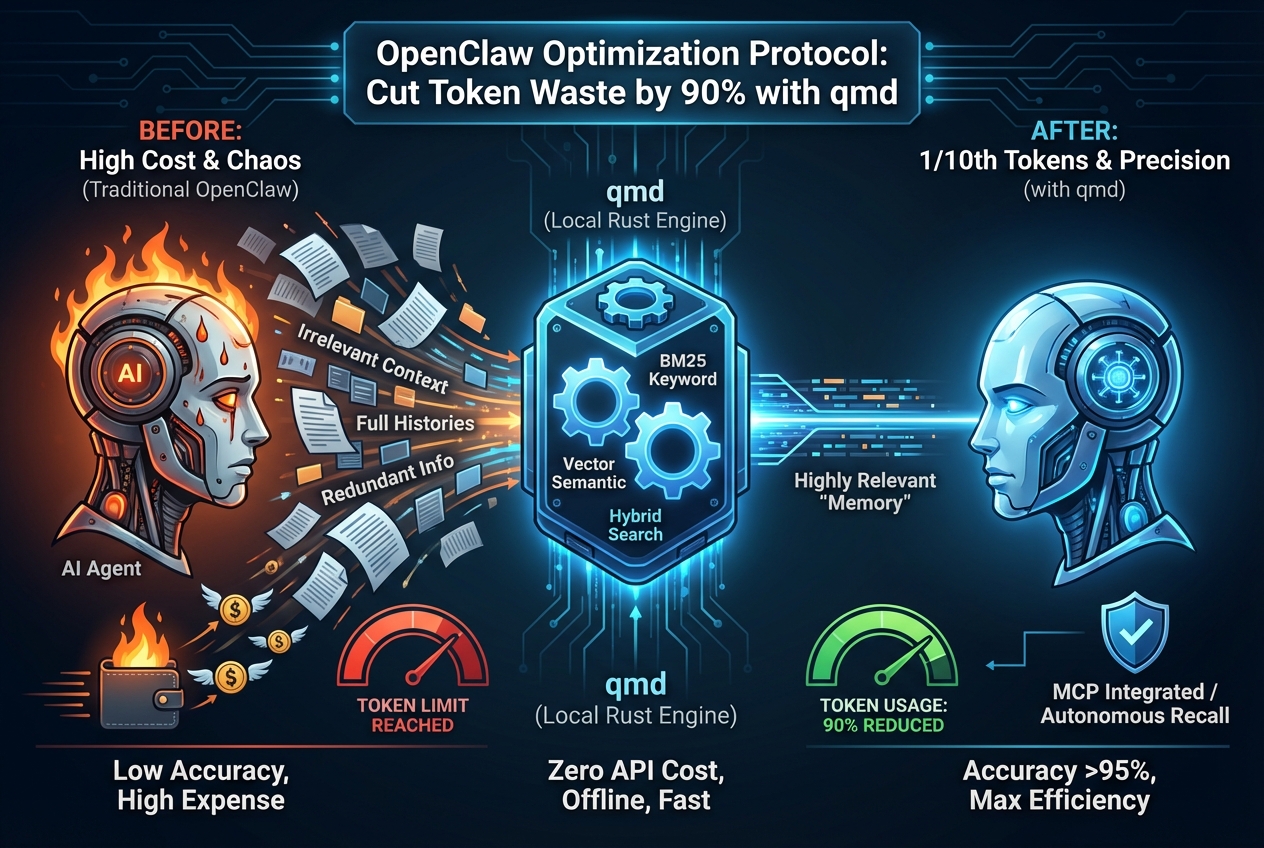

5. ハイブリッドRAG (Hybrid RAG) – "いいとこ取り"の最強検索

ベクトル検索(意味の類似性)と、従来のキーワード検索(BM25など)やグラフ検索(構造的関係性)は、それぞれ得意なことが異なります。ならば、それらを組み合わせればもっと強力になるはず、という発想が「ハイブリッドRAG」です。図ではベクトル検索とグラフ検索を併用しています。

仕組み

- 並列検索: ユーザーのクエリを、ベクトルDBとグラフDB(または他の検索システム)の両方に同時に投げかけます。

- 結果の統合(Fusion): それぞれの検索エンジンから返された結果を統合します。この統合ステップが重要で、単純に結果を連結するのではなく、Reciprocal Rank Fusion (RRF) のようなアルゴリズムを用いて、両方のランキングを考慮した上で最終的な順位を決定します。

- 生成: 統合・再ランク付けされた、よりリッチで多角的なコンテキストをLLMに渡して回答を生成させます。

メリット

- 網羅性と精度の両立: ベクトル検索が捉えきれない固有名詞や専門用語はキーワード検索が補い、複雑な関係性はグラフ検索が補うなど、互いの弱点を補完しあうことで、非常にロバストな検索性能を実現します。

RAGの未来:エージェント型アーキテクチャ

ここからは、RAGが単なる「検索して生成する」仕組みから、自律的に思考し、行動するシステムへと進化する「エージェント型RAG」を見ていきます。

6. エージェント型RAG(ルーター)- 賢い交通整理役

クエリの種類によって、最適な情報源は異なります。「エージェント型RAG(ルーター)」は、この「どこに聞くべきか?」という判断を自動化するアーキテクチャです。

仕組み

- クエリ分析: ユーザーのクエリを、まず司令塔となる「AIエージェント(ルーターエージェント)」が受け取ります。

- ルーティング(経路選択): エージェントはLLMの能力を使い、クエリの内容を分析します。「これは製品仕様に関する質問だから、ベクトルDB A(技術文書)に問い合わせよう」「これは社内規定に関する質問だから、ベクトルDB B(社内規程)に問い合わせよう」というように、最適な情報源や処理経路を動的に決定します。

- 委任と実行: 決定した経路に従って、後続のRAGパイプラインを実行し、コンテキストを取得して回答を生成します。

このアーキテクチャにより、用途別にサイロ化された複数の知識ベースを、単一のインターフェースでシームレスに横断検索できるようになります。

7. エージェント型RAG(マルチエージェント)- 専門家チームによる問題解決

これは現時点で最も高度かつ強力なRAGの形態であり、もはやRAGというより「RAGをツールとして使いこなすエージェントシステム」と呼ぶべきものです。

仕組み

このアーキテクチャでは、複数の専門家エージェントが協調してタスクを解決します。

- タスク分解と計画: 親となるオーケストレーターエージェントがユーザーからの複雑なリクエスト(例:「最新の競合製品Xの市場評価を調査し、社内の関連部署のSlackでの反応をまとめ、報告書としてGmailで私に送って」)を受け取ります。そして、このタスクを達成するためのステップを計画し、小さなサブタスクに分解します。

- ツールとエージェントの選択: 各サブタスクを実行するために最適な「ツール」を選択します。図のツールには、社内DBを検索するRAGエージェント、Web検索を行うエージェント、Slackと連携するエージェント、Gmailを操作するエージェントなどが含まれます。

- 協調作業: オーケストレーターは、各専門エージェントにサブタスクを割り振ります。Web検索エージェントが市場評価を調べ、RAGエージェントが社内Slackのログを検索し、その結果をオーケストレーターに報告します。

- 統合と最終生成: オーケストレーターは、各エージェントから集まった情報を統合・要約し、最終的な報告書を生成します。そして、Gmailエージェントにその報告書を送信するように指示します。

インパクト

マルチエージェントRAGは、単一の質問に答えるだけでなく、複数のステップにまたがる複雑なワークフローを自動化する能力を持ちます。これは、AIが人間の知的作業を真に代行する未来を垣間見せる、非常にパワフルなパラダイムです。

まとめと展望

この2 Partにわたる解説で、RAGが単一の技術ではなく、目的に応じて進化・発展する広大なアーキテクチャ群であることがお分かりいただけたかと思います。

- **基本形(ナイーブRAG, Rerank)**で土台を築き、

- **応用形(マルチモーダル, グラフ, ハイブリッド)**で対応範囲と精度を広げ、

- **未来形(エージェント型)**で自律的な問題解決能力を獲得する。

RAGの進化はまだ始まったばかりです。今後、より洗練された検索アルゴリズム、より賢いエージェント、そしてより多様なツールとの連携が進むことで、AIと人間が協働する未来はさらに現実のものとなるでしょう。皆さんのビジネスやプロジェクトに、どのRAGアーキテクチャが最適か、この記事がその検討の一助となれば幸いです。

参考アーキテクチャー図

コメントを残す